人工智能会威胁人类生存吗

2014年,SpaceX的首席履行官埃隆·马斯克发了1条推特:“博斯特罗姆的《超级智能》值得1读,对人工智能1定要万分谨慎,它可能比核弹还危险。”同1年,剑桥大学宇宙学家霍金对BBC说:“开发完全的人工智能可能致使人类灭亡。”微软开创人之1比尔·盖茨也曾警惕地表示:“我是对超级智能感到耽忧的那1派。”

2008年,计算机科学家埃利泽·尤得库斯基在《全球灾害风险》中刻画了AI灭世的场景:“AI的智力从阿米巴1路上升到村里的笨蛋那个级别,然后止步于人类天才的水平,这样的可能性有多大?”他自己的回答是:“从物理上说,我们有可能造出1台运算速度百万倍于人脑的计算机。如果人脑加速到这个水平,那末从前需要思考1年的问题,现在31秒以内就可以解决。而这就意味着,外界才过8个半小时,内心就已感觉经历了近千年的思考时间。”尤得库斯基认为,现在不为这个问题着想,以后就来不及了:“AI的时间观念和你我不同,等到你的神经元想好‘我该做点甚么’时,你就已输了。”

这派想法的代表是牛津大学哲学家尼克·博斯特罗姆在《超级智能》1书中提出的所谓“回形针量产机”的思惟实验:人类设计了1台AI来造回形针,它在耗尽了最初的原料以后,就开始极力搜索1切可用的材料,包括人类身上的那些。博斯特罗姆在2003年的1篇论文中写道,只要这个头1开,AI就会“先将全部地球耗尽,乃至进1步利用周围更大范围内的所有材料,把它们都改造成1部部生产回形针的装置。”用不了多久,全部宇宙就只剩下回形针和生产回形针的机器了。

我对这个假想持怀疑的态度。第1,这个末日场景需要满足1连串条件才能实现,中间任何1个环节出错,末日的戏码都没法上演。英国西英格兰大学的电气工程教授艾伦·温菲尔德在2014年的1篇文章中这样写道:“假设我们造出了和人类相当的AI,假设这部AI明白了本身的工作原理,又假设它能将自己改进成具有超级智能的AI,再假设这个超级AI出于无意或歹意开始消耗资源,还要假设我们没能拔掉它的插头?到那时,我们才可能遇到麻烦。这风险不是没有,只是几率甚微。”

第2,AI的研发其实要比预测的缓慢很多,其中每个步骤,人类都有时间叫停。就像谷歌董事长埃里克·施密特在回复马斯克和霍金时所说的那样:“你们觉得人类会注意不到吗?注意到以后,不会去关掉那些电脑吗?”谷歌的DeepMind公司已发展出了1个关闭AI的开关,它被戏称为“紧急红按钮”,可以在AI意图造反时按下。百度首席科学家吴恩达也表示(针对马斯克的话),有人“还没登上火星,就开始耽忧火星上的人口问题了。”

第3,AI灭世论的根据常常是天然智能和人工智能之间的毛病类比。2015年,哈佛大学的实验心理学家斯蒂芬·平克在回答Edge网站年度问题“你对会思考的机器有甚么看法”时,对这1点做了说明:“AI灾害论者都在智能的概念中投射了狭隘的大男子心态。他们假定智力超出人类的机器人会制定出免职主人或是统治世界的目标。”但实际上,平克指出,人工智能一样可能“沿着女性的线路进化:既能熟练地解决问题,又没有消灭无辜者或主宰人类文明的愿望。”

第4,电脑“想做”某事的说法(比如想把世界变成回形针)意味着电脑有了情绪,但是就像科普作家迈克尔·乔罗斯特指出的那样:“1旦AI对某事有了向往,它就进入了1个奖赏与惩罚的世界,比如它会知道,做了坏事就要遭到我们的惩罚。”

斟酌到历史上的末日预言还没有1个应验,再加上AI几10年来的发展1向平缓,我们应当有充裕的时间建立1套安全部系,以避免AI毁灭世界的事情产生。

-

王栎鑫娇妻与女儿强势同框王大姐躲床头实力

自从娱乐圈刮起晒娃风后,很多明星夫妻也不再将婚姻藏得严严实实,不仅夫妻之间会高调秀恩爱,对儿女的生活...[详细]

-

中印现在有多紧张连在印旅游的台湾人都倒霉

中印边境的紧张局势也波及到了台湾。27日 , 两名台湾大学生赴印度旅游 , 在靠近克什米尔的喜马偕尔邦首府西姆拉...[详细]

-

随性又百搭千万不要错过这件单品

原标题:随性又百搭,千万不要错过这件单品 很多人的印象里Polo衫和时尚没什么关系 能穿它的场合只有运动的时...[详细]

-

尹正发了一条微博陈赫看到后转发评论说准备

相信一提到尹正和陈赫的关系,那绝对可以说是好的穿一条裤子都嫌弃裤子太肥的那种,两人不仅在综艺节目上打...[详细]

-

时代影响力发片单王朔编剧新作不老奇事将拍

原标题:时代影响力发片单 王朔编剧新作《不老奇事》将拍 时代影响力发布会 搜狐娱乐讯 (哈麦 文 小明 视频)...[详细]

-

裴勇俊朴秀珍二胎女儿凌晨出生母女均平安

裴勇俊 朴秀珍新浪娱乐讯 韩国演员裴勇俊、朴秀珍的二胎女儿于10日顺利出生。据某媒体10日的报道,裴勇俊于10日...[详细]

-

-

爱科百发宣布抗呼吸道合胞病毒(RSV)新药齐瑞索韦治疗婴幼儿患者3期临床研究结果发表于《新...

上海2024年9月26日 /美通社/ -- 北京

-

依视路陆逊梯卡出席2024世界近视眼大会,聚力近视管理新路径

前瞻研究引领,近视预防与控制并重 上海2024

-

大家保险携海南卫视共推《乐龄说》

分享养老服务解决方案 共话养老生活新未来

-

联合利华饮食策划聚焦餐饮创新发展,赋能餐饮消费"新食尚"

北京2024年9月26日 /美通社/ -- 今日,由国家市场

-

《都市人群科学护肝白皮书》出炉

BYHEALTH汤臣倍健给大众更科学的护

-

健络通25周年 「壹点宁 清凉」薄荷冰凉 助你随时随地纾缓多种疼痛

香港2024年9月27日 /美通社/ --健络

-

-

-

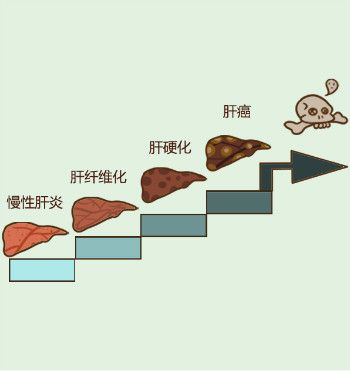

肝纤维化不能吃什么?肝纤维化饮食的注意事项有哪些?

中国人口14亿多,其中有9000万乙肝病毒感染者

-

肝硬化需要全疗程用药吗?哪个品牌的软肝片好?用药讲疗程,安全有保证!

人们常说“慢性病要以慢治慢”。古人倡导“

-

肝硬化的突出表现有哪些?用什么药软肝效果好?保肝软肝就选中成药

肝硬化是一种常见慢性病,引起肝硬化的病因

-

肝硬化的前期表现有哪些?肝硬化前期该如何选择软肝药品呢?

中国人的饮酒文化众所皆知,都特别喜欢酒桌

-

肝硬化患者吃什么药好,复方鳖甲软肝片有效吗?疗效值得认可

我国是肝病高发生率大国,每年有超过120万病

-

肝硬化吃复方鳖甲软肝片怎么样?复方鳖甲软肝片功效与作用来评价

肝硬化是一种常见的慢性肝病,是由一种或多

-

-

-

-

-

-

-

-

-

-

-

-

优养在线

优养在线